✅OpenVINO™ AI – Giải pháp tăng tốc Trí tuệ Nhân tạo tối ưu cho mọi nền tảng

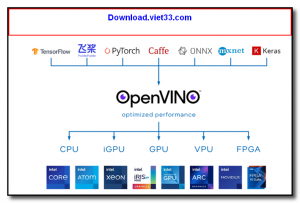

Bạn đang tìm kiếm một công cụ mạnh mẽ giúp đưa mô hình AI từ ý tưởng đến ứng dụng thực tế với tốc độ vượt trội? OpenVINO™ AI chính là giải pháp dành cho bạn! Đây là bộ công cụ tối ưu hóa và triển khai mô hình AI mã nguồn mở do Intel phát triển, giúp rút ngắn thời gian xử lý, tăng hiệu suất và mở rộng khả năng ứng dụng trong nhiều lĩnh vực như: thị giác máy tính, xử lý ngôn ngữ tự nhiên, IoT, y tế, bán lẻ, sản xuất và nhiều ngành công nghiệp khác.

✅ Công dụng nổi bật:

-

Tăng tốc hiệu năng AI: Giúp mô hình chạy nhanh hơn gấp nhiều lần trên CPU, GPU, VPU và FPGA mà không cần thay đổi cấu trúc mô hình.

-

Tối ưu hóa mô hình: Giảm dung lượng, tiết kiệm bộ nhớ và cải thiện khả năng phản hồi thời gian thực.

-

Đa nền tảng – đa thiết bị: Tương thích với Windows, Linux, macOS, cũng như các thiết bị nhúng và IoT.

-

Khả năng triển khai linh hoạt: Hỗ trợ nhiều framework phổ biến như TensorFlow, PyTorch, ONNX, Caffe…

-

Tiết kiệm chi phí: Giúp tận dụng tối đa phần cứng sẵn có mà không cần đầu tư thêm thiết bị đắt đỏ.

✅ Tính năng chính:

-

Model Optimizer – Công cụ chuyển đổi mô hình từ nhiều framework sang định dạng trung gian IR, giúp dễ dàng triển khai trên nhiều thiết bị.

-

Inference Engine – Thư viện thời gian chạy tối ưu, cho phép mô hình thực thi nhanh chóng với hiệu suất cao.

-

Post-training Optimization Toolkit – Hỗ trợ giảm độ chính xác (quantization), pruning và các kỹ thuật tối ưu nâng cao.

-

Deep Learning Workbench – Giao diện trực quan, dễ dàng phân tích, tinh chỉnh và so sánh hiệu năng mô hình.

-

Hỗ trợ plugin đa dạng – Cho phép chạy mô hình trên CPU, GPU, FPGA, VPU chỉ với vài dòng lệnh thay đổi.

✅ Cách sử dụng chi tiết:

-

Cài đặt OpenVINO

-

Tải về từ trang chính chủ: Download.viet33.com

-

Cài đặt với lệnh đơn giản hoặc sử dụng Docker để triển khai nhanh.

-

-

Chuyển đổi mô hình

-

Sử dụng Model Optimizer để biến đổi mô hình TensorFlow/PyTorch sang định dạng IR.

-

Quá trình này giúp giảm dung lượng và chuẩn hóa mô hình cho phù hợp với OpenVINO.

-

-

Triển khai mô hình

-

Dùng Inference Engine API (Python, C++, Java) để gọi mô hình trong ứng dụng.

-

Chọn thiết bị chạy (CPU/GPU/VPU/FPGA) chỉ bằng một tham số duy nhất.

-

-

Tối ưu hóa & Giám sát

-

Dùng Deep Learning Workbench để đánh giá tốc độ, độ chính xác, và tự động gợi ý tối ưu.

-

Áp dụng quantization để giảm kích thước mô hình nhưng vẫn giữ độ chính xác ở mức cao.

-

✅ Lợi ích khi sử dụng OpenVINO AI:

-

Đưa ý tưởng AI vào thực tế nhanh hơn.

-

Triển khai trên nhiều môi trường mà không lo rào cản phần cứng.

-

Giảm chi phí phát triển & vận hành hệ thống AI.

-

Được cộng đồng mã nguồn mở và Intel hỗ trợ thường xuyên, liên tục cập nhật công nghệ mới.

👉 Với OpenVINO AI, bạn không chỉ chạy mô hình AI – bạn còn tăng tốc, tối ưu và mở rộng khả năng ứng dụng AI lên một tầm cao mới. Đây chính là công cụ mà bất kỳ nhà phát triển, kỹ sư dữ liệu hay doanh nghiệp nào đang ứng dụng AI đều nên sở hữu.

Download AutoIt – phần mềm và ngôn ngữ kịch bản (script)

1206 Lượt tải

Download AutoIt – phần mềm và ngôn ngữ kịch bản (script)

1206 Lượt tải

Download OpenCart– Giải pháp tạo website bán hàng chuyên nghiệp, miễn phí

1437 Lượt tải

Download OpenCart– Giải pháp tạo website bán hàng chuyên nghiệp, miễn phí

1437 Lượt tải

Download CONSTRUCT 2– PHẦN MỀM LÀM GAME 2D KHÔNG CẦN BIẾT LẬP TRÌNH

2396 Lượt tải

Download CONSTRUCT 2– PHẦN MỀM LÀM GAME 2D KHÔNG CẦN BIẾT LẬP TRÌNH

2396 Lượt tải

Download MARYFI– BIẾN MÁY TÍNH CỦA BẠN THÀNH ĐIỂM PHÁT WIFI

2372 Lượt tải

Download MARYFI– BIẾN MÁY TÍNH CỦA BẠN THÀNH ĐIỂM PHÁT WIFI

2372 Lượt tải

Download Bitwar Data Recovery– Giải Pháp Khôi Phục Dữ Liệu An Toàn & Hiệu Quả

4274 Lượt tải

Download Bitwar Data Recovery– Giải Pháp Khôi Phục Dữ Liệu An Toàn & Hiệu Quả

4274 Lượt tải