✅ONNX Runtime – Bộ tăng tốc AI tối ưu hiệu suất mô hình mạnh mẽ nhất hiện nay

Bạn đang có mô hình AI/ML nhưng chạy quá chậm?

Bạn cần tăng tốc inference cho sản phẩm AI của mình để đưa vào sản phẩm thực tế, app, web, game, robot, IoT… với tốc độ nhanh hơn, ổn định hơn, chi phí rẻ hơn?

ONNX Runtime chính là giải pháp!

ONNX Runtime là nền tảng tăng tốc AI mã nguồn mở do Microsoft phát triển, cho phép chạy các mô hình AI đã huấn luyện trên mọi nền tảng – nhanh hơn, nhẹ hơn và tối ưu hơn so với chạy trực tiếp framework gốc.

✅Công dụng & hiệu quả thực tế của ONNX Runtime

-

Tăng tốc inference AI lên đến x10 tốc độ

-

Tiết kiệm tài nguyên phần cứng – chạy ổn định cả trên CPU yếu, Edge Device, IoT

-

Giảm chi phí deploy model (bớt tiền GPU, điện, cloud)

-

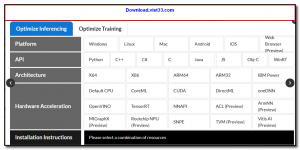

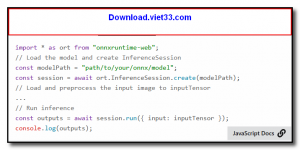

Dễ deploy đa môi trường (Windows, Linux, MacOS, Android, iOS, Web, Cloud)

Đây là thư viện đang được dùng trong Production bởi các tập đoàn lớn toàn thế giới.

✅Những tính năng nổi bật

| Tính năng | Mô tả |

|---|---|

| Hỗ trợ đa framework | Tương thích PyTorch, TensorFlow, Scikit-Learn, Transformer HuggingFace,… |

| Đa nền tảng | Desktop – Mobile – WebAssembly – IoT – Cloud |

| Multi Backend | CPU, GPU CUDA, ROCm, DirectML, OpenVINO, TensorRT |

| Dễ tối ưu model | Có sẵn Graph Optimization, Quantization, Ep Execution Providers |

| Open Source hoàn toàn | Free – Có cộng đồng cực mạnh – Hỗ trợ tốt trong enterprise |

✅Cách sử dụng ONNX Runtime đơn giản (chỉ 3 bước)

Bước 1: Convert model sang ONNX

Từ PyTorch/TensorFlow chỉ 1 lệnh export

Bước 2: Cài ONNX Runtime

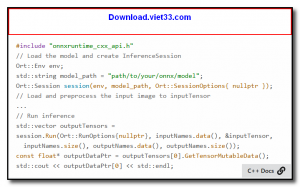

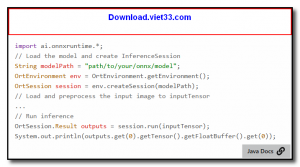

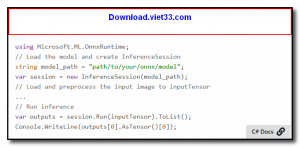

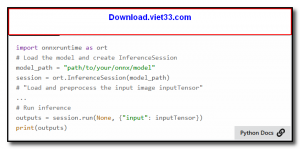

Bước 3: Load & chạy inference cực nhanh

Chỉ cần 3 dòng code bạn đã có thể tăng tốc AI của mình mà không cần chỉnh lại mô hình.

✅Kết luận

Nếu bạn làm AI / Data Science / App AI / Game AI / Trading AI / Automation AI

→ ONNX Runtime là công cụ bắt buộc phải có trong stack phát triển của bạn.

Nhanh hơn – Rẻ hơn – Hiệu quả hơn – Triển khai dễ hơn.

ONNX Runtime giúp AI của bạn hoạt động thực sự mạnh ở môi trường thực tế, không chỉ trong phòng lab.

Download Videoder– Giải pháp tải video & nhạc chất lượng cao, nhanh gọn và cực kỳ tiện lợi

210 Lượt tải

Download Videoder– Giải pháp tải video & nhạc chất lượng cao, nhanh gọn và cực kỳ tiện lợi

210 Lượt tải

Download CyberLink YouCam– Biến Webcam Của Bạn Thành Studio Chuyên Nghiệp

839 Lượt tải

Download CyberLink YouCam– Biến Webcam Của Bạn Thành Studio Chuyên Nghiệp

839 Lượt tải

Download HiBit Uninstaller

1540 Lượt tải

Download HiBit Uninstaller

1540 Lượt tải

Download Tomabo MP4 Player

1386 Lượt tải

Download Tomabo MP4 Player

1386 Lượt tải

Download AutoIt – phần mềm và ngôn ngữ kịch bản (script)

3073 Lượt tải

Download AutoIt – phần mềm và ngôn ngữ kịch bản (script)

3073 Lượt tải